conda 常用命令

鉴于经常忘记,记录一下 conda 常用操作

换源

参照 tuna 的 anaconda 源配置

https://mirrors.tuna.tsinghua.edu.cn/help/anaconda/

创建环境

conda create -n spider python=3.6

查看环境

conda env list

切换环境

conda activate spider

鉴于经常忘记,记录一下 conda 常用操作

参照 tuna 的 anaconda 源配置

https://mirrors.tuna.tsinghua.edu.cn/help/anaconda/

conda create -n spider python=3.6

conda env list

conda activate spider

声明:本文分析的样例 app、相关分析工具均来源于互联网,仅供研究测试之用,严禁传播和用于非法用途。否则所产生的一切后果由读者自行承担,本网站及发帖人不承担任何责任。样例 app 已于发文后删除。

最近尝试抓某 app 的接口,此 app 使用 HTTPS 协议通讯,并且做了 SSL pinning 阻止用户使用自定义的第三方证书,导致所有抓包工具均无解。经过尝试一些主流的 xposed 模块均无法绕过,一旦检测到用户使用第三方证书,app 就不再进行网络连接:

2019/8/21 Update: 已经有人部署到网站 selife2anime.com

2019/8/21 Update: 已经有人部署到网站 selife2anime.com

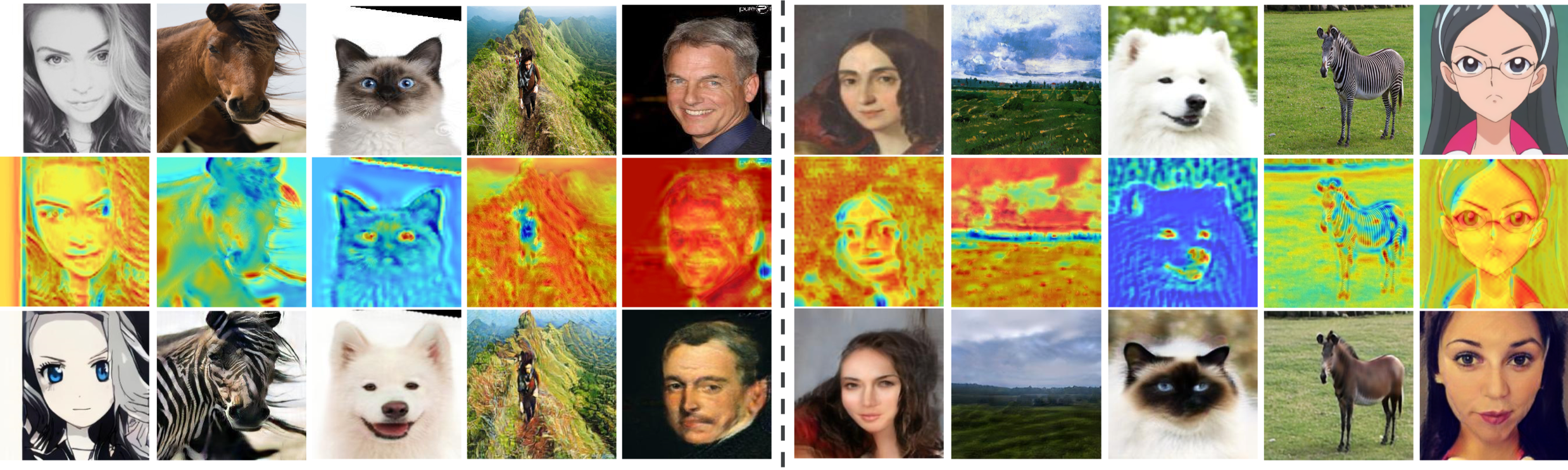

UGATIT是一个由韩国NCSOFT公司开源的非监督GAN网络,这个GAN网络使用了新的改进的注意力模块能更好的关注几何和整体变化;以及使用新的AdaLIN (Adaptive Layer-Instance Normalization) 函数从数据集中学习参数,来灵活控制对材质和形状的修改(个人理解为更精细的生成?)。GitHub上开源了其TensorFlow版和PyTorch版。

使用恰当的数据集,可以训练妹子->二次元 or 二次元->妹子的模型,8说了,准备数据集,开冲!

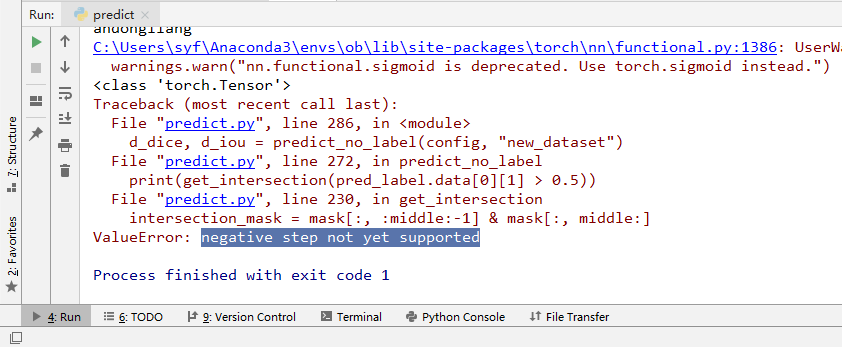

预测出的嗅球和白色部分需要验证是否正确,因为嗅球和白色部分比较对称,所以有个朴素的方法:将预测出的mask从中间折叠,计算重合部分占比,占比过小的认为是无效预测

然而在实现时发现pytorch的Tensor不支持负数作为步长:

Google之后发现:这2个issue:

在第二个issue里可以看到这个问题的历程: